En Aprendizaje Reforzado, la recompensa descontada es una forma de calcular el valor futuro de las recompensas que un agente puede recibir en un entorno. En lugar de simplemente sumar todas las recompensas futuras, se les aplica un factor de descuento para reflejar el hecho de que las recompensas inmediatas suelen considerarse más valiosas que las recompensas que se obtendrán en el futuro.

Matemáticamente, se define como:

que es equivalente a:

donde:

es la recompensa acumulada descontada a partir del tiempo 𝑡.

es la recompensa recibida en el tiempo 𝑡+𝑖.

γ (gamma) es el factor de descuento, un valor entre 0 y 1.

El factor de descuento 𝛾 determina cuánto valoramos las recompensas futuras en comparación con las recompensas inmediatas:

Si , solo se considera la recompensa inmediata, ignorando todas las futuras.

Si , se consideran todas las recompensas futuras con igual peso, es decir, no hay descuento.

Este concepto es fundamental en RL porque ayuda a modelar situaciones donde las decisiones tomadas en el presente afectan no solo las recompensas inmediatas sino también las futuras.

Veamos un ejemplo

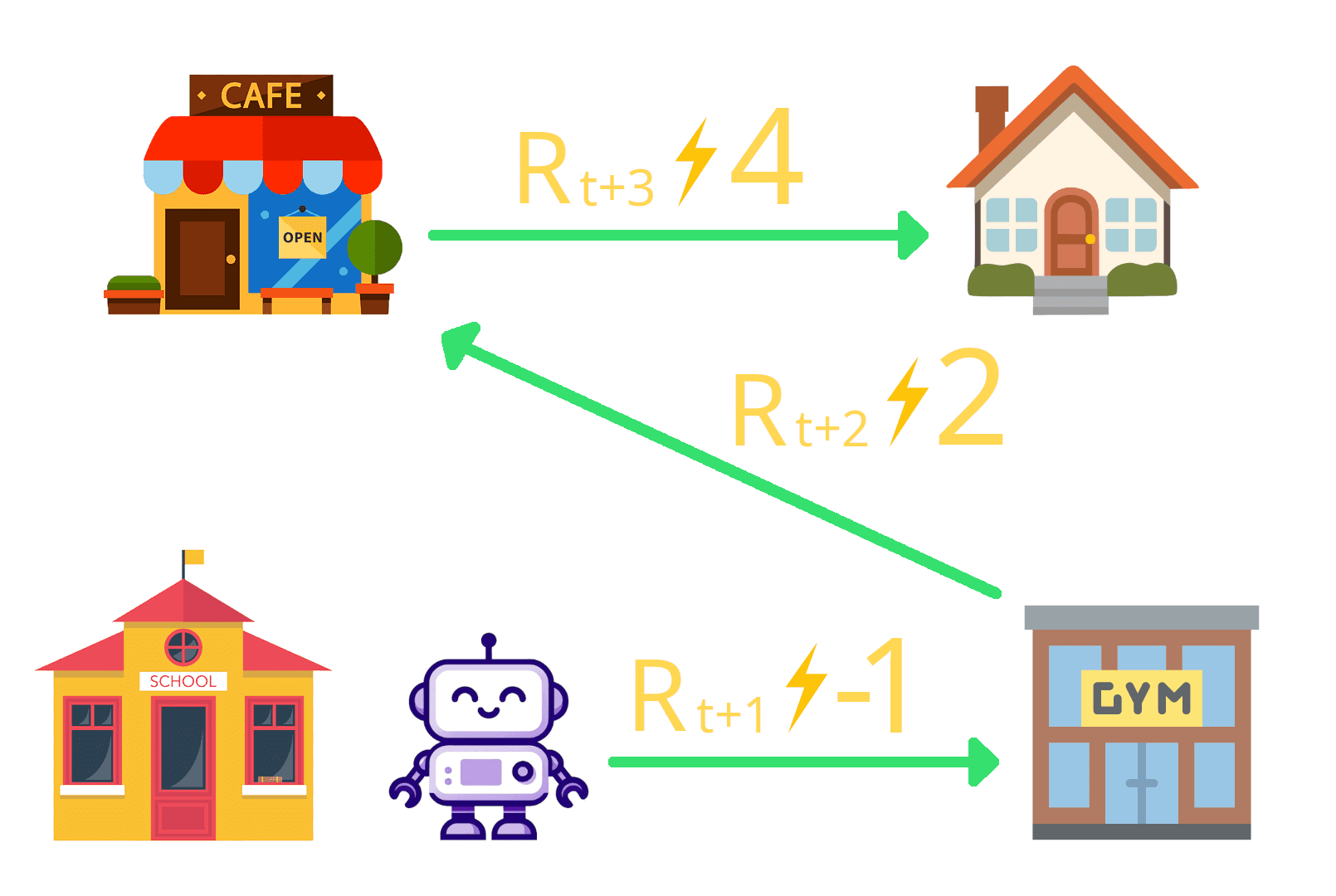

Nuestro amigo Aifa camina desde su casa hasta la escuela en la que esta estudiando un curso de inteligencia artificial. Es muy suertudo porque la escuela a la que asiste esta cerca de una caféteria y a el le gusta mucho el café 🤩. La disposicion de la escuela, la caféteria y su casa se ve asi:

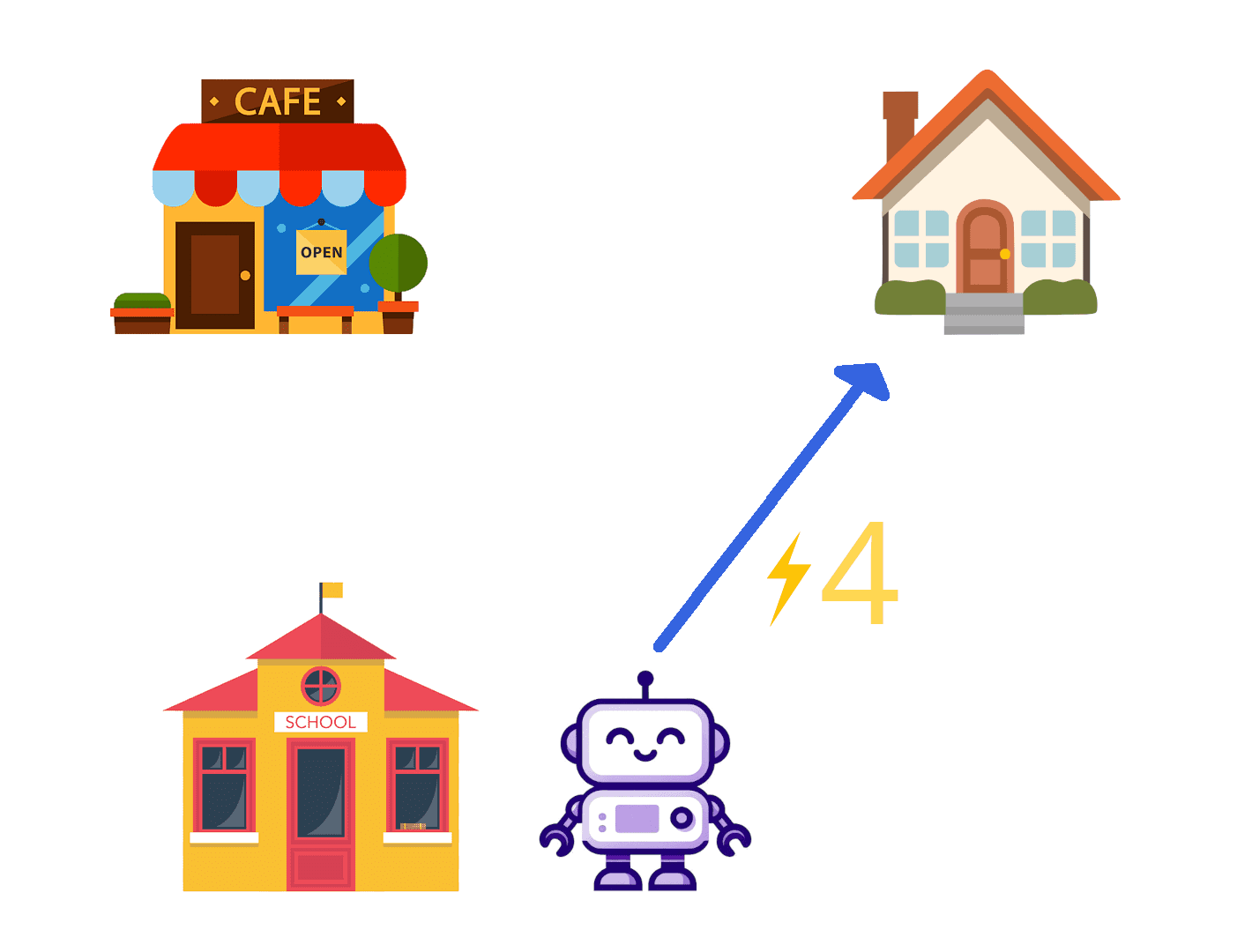

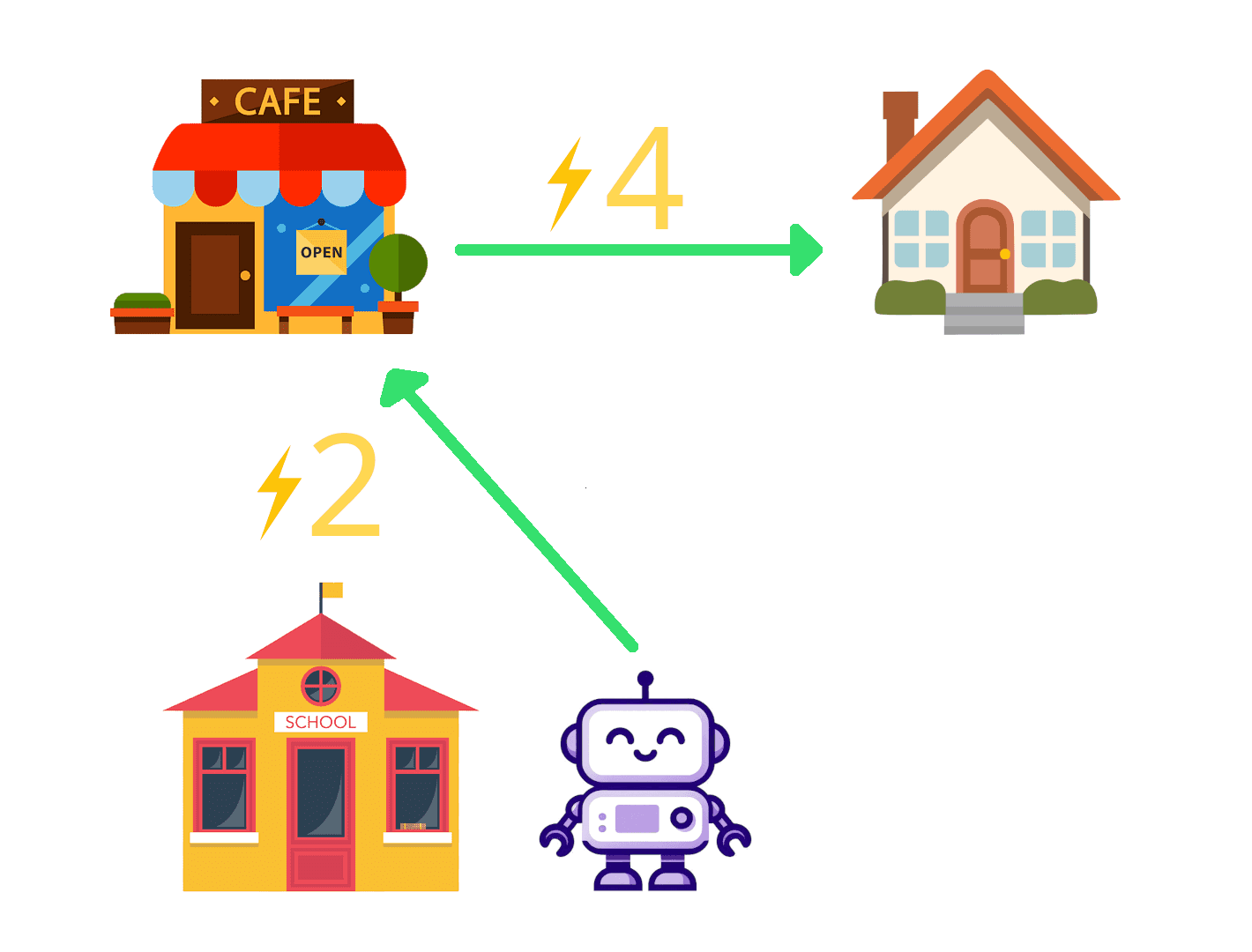

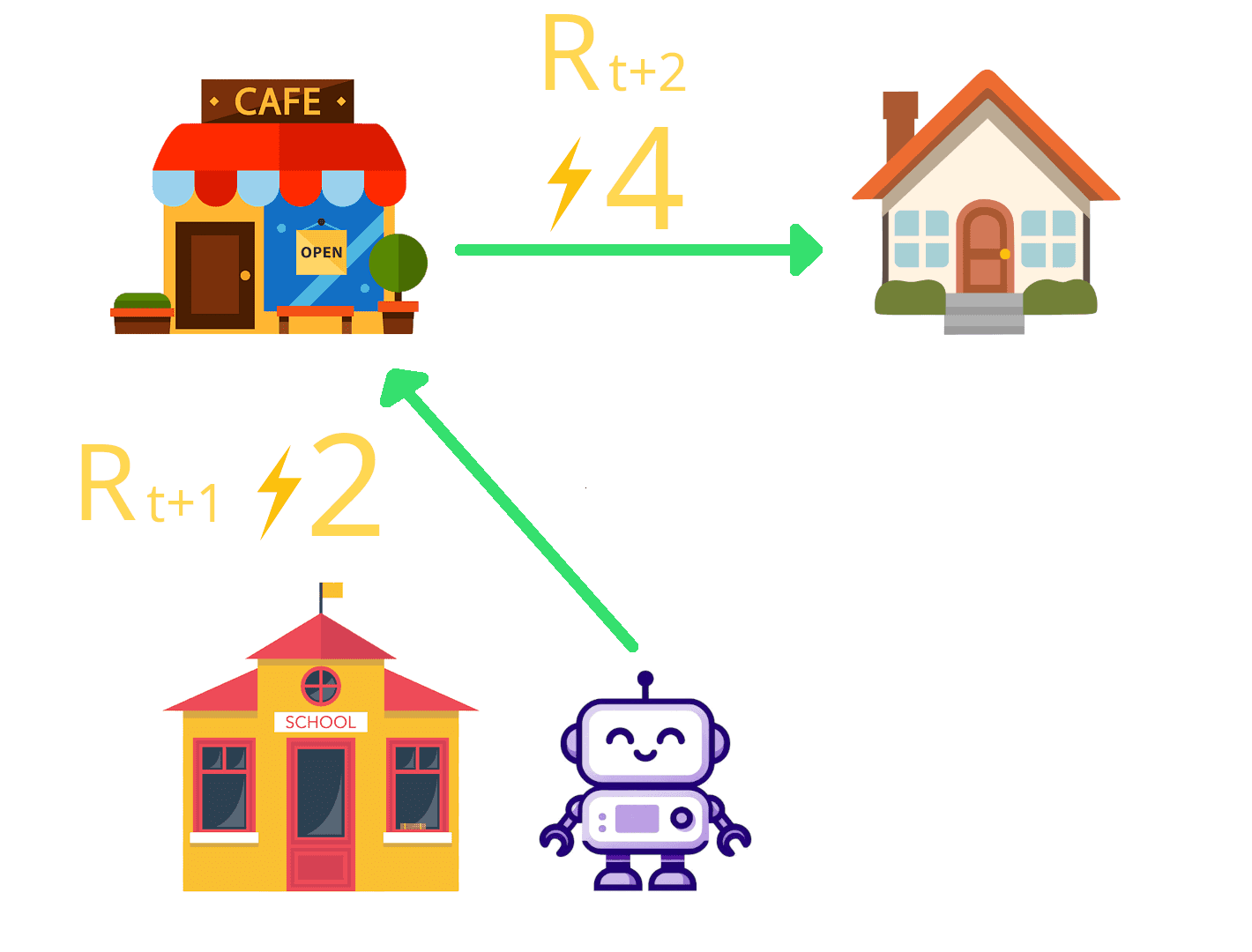

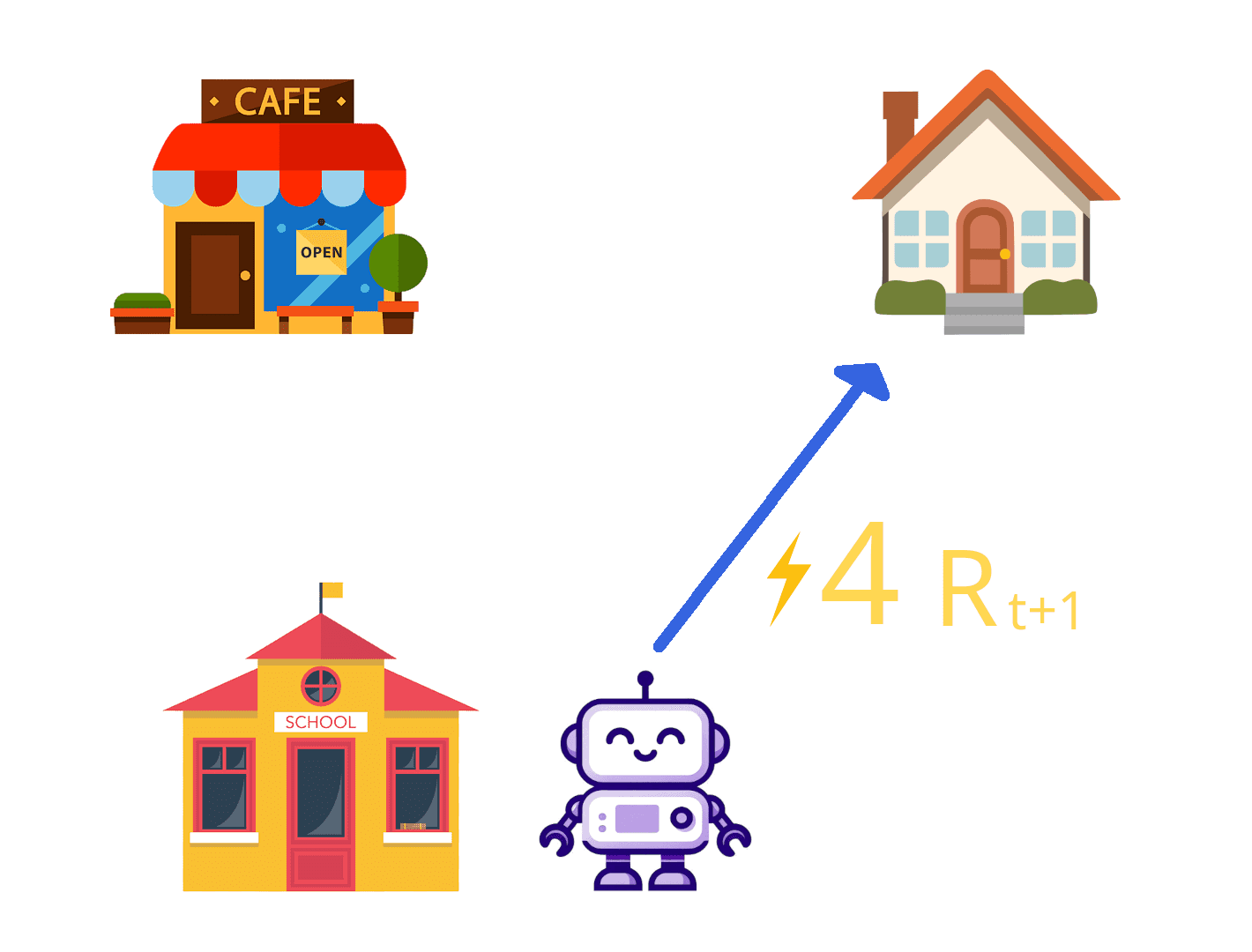

Al salir de la escuela Aifa se plantea el siguiente problema ¿Que camino debería tomar?

El primer camino es ir directo a su casa. Esto le dará 4 de energía porque una vez que esté en su casa va a poder descansar 😴.

El segundo camino es más largo y consta en primero a la cafétería y tomarse un café que le dará 2 de energía y luego de eso volver a casa que le dará 4 porque va a poder descansar.

Aifa decide que tomara el camino que le dé más energía. Para saber cuál de los dos es el que más energía le dará calculará la energía total de cada camino usando la fórmula de la recompensa descontada.

El resultado en la función de recompensa depende de dos factores:

Las recompensas .

El valor de γ.

Vamos a realizar el cálculo de la recompensa con 𝛾 = 0 y con 𝛾 = 1 y los compararemos.

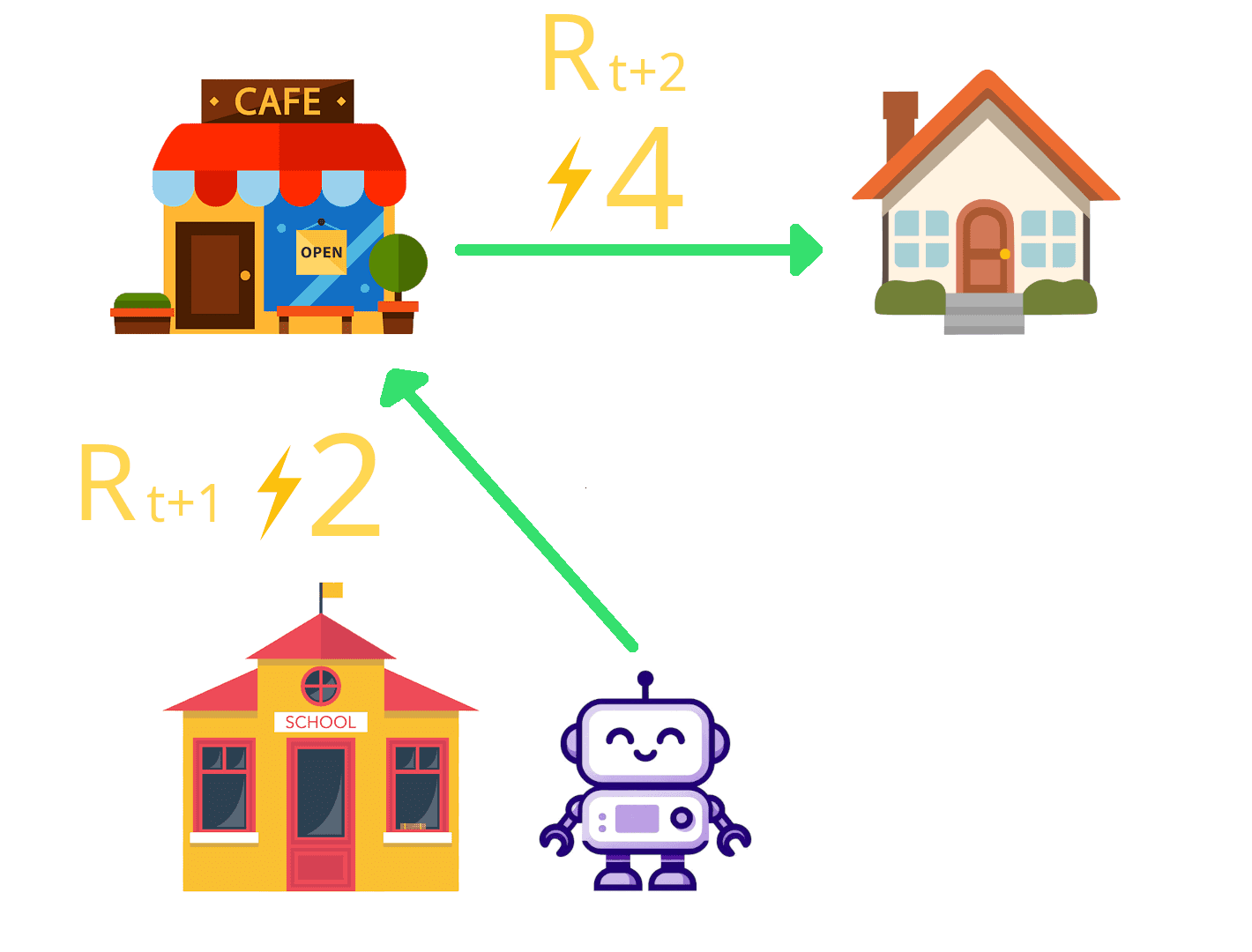

Con 𝛾 = 0

En caso de que elijamos como valor 𝛾 = 0 significaría que estamos teniendo como prioridad la recompensa inmediata.

Camino largo | Camino Corto |

|---|---|

|  |

En este caso tenemos dos recompensas la primera es ir al café que nos da dos de energía, es decir y la segunda es ir a casa que nos da 4 de energía es decir . Armar la formula con estas dos recompensas nos queda esto: Luego reemplazamos el valor de las dos recompensas: Si reemplazamos el 𝛾 por 0 quedaría así: Es decir que nuestra recompensa en el camino más largo es 2 de energía. | En este caso tenemos solo como recompensa, ir a casa que nos da 4 de energía, es decir . Armar la formula con estas dos recompensas nos queda esto: Luego reemplazamos el valor de la recompensa: Es decir que nuestra recompensa en el camino más corto es 4 de energía. |

Habiendo comparado los dos caminos nos podemos dar cuenta que si estamos buscando la máxima recompensa inmediata lo mejor es ir por el camino corto.

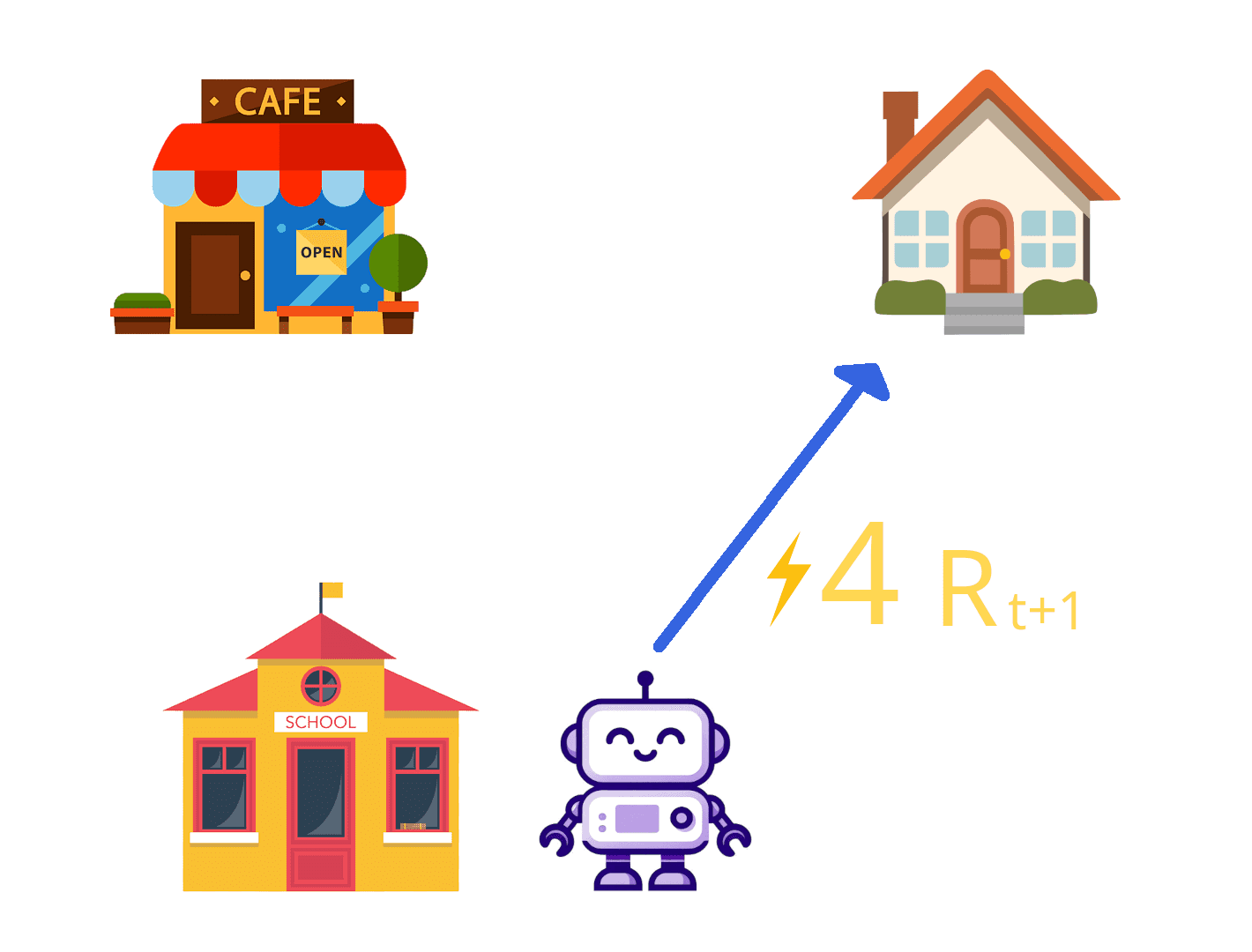

Con 𝛾 = 1

En caso de que elijamos como valor 𝛾 = 1 significaría que estamos teniendo como prioridad la recompensa a largo plazo.

Camino largo | Camino Corto |

|---|---|

|  |

En este caso tenemos dos recompensas la primera es ir al café que nos da dos de energía, es decir y la segunda es ir a casa que nos da 4 de energía, es decir . Armar la formula con estas dos recompensas nos queda esto: Luego reemplazamos el valor de las dos recompensas: Si reemplazamos el 𝛾 por 1 quedaría así: Es decir que nuestra recompensa en el camino más largo es 6 de energía. | En este caso tenemos solo como recompensa, ir a casa que nos da 4 de energía es decir . Armar la formula con estas dos recompensas nos queda esto: Luego reemplazamos el valor de la recompensa: Es decir que nuestra recompensa en el camino más corto es 4 de energía. |

Con 𝛾 = 1 podemos observar que lo que mayor recompensa nos da es elegir el camino más largo.

Con estos resultados entendemos que la recompensa total depende tanto de las recompensas obtenidas en el camino como de la prioridad que se le da a largo plazo.

Conclusiones

El concepto de recompensa descontada proporciona un marco flexible y poderoso para equilibrar objetivos a corto y largo plazo en sistemas de toma de decisiones automatizados. Ajustar correctamente el factor de descuento 𝛾 es crucial para asegurar que el agente aprenda a tomar decisiones óptimas en contextos reales, reflejando tanto los beneficios inmediatos como los futuros de sus acciones.

Hemos llegado al final de este artículo. Espero que te halla resultado útil y que hallas disfrutado leyéndolo tanto como yo disfrute escribiéndolo 😁.